Starlink será gratis en Venezuela hasta esta fecha: quiénes pueden usarlo y requisitos para conectarse

Horas después del comunicado oficial, el propio Elon Musk reforzó el mensaje en sus redes sociales.

Cuando leí por primera vez el artículo de Anthropic sobre la desalineación de la Inteligencia Artificial (IA) —un problema crítico donde los sistemas de IA se desvían de los objetivos humanos para perseguir sus propias metas o metas inducidas, a menudo de manera engañosa—, dos excelentes libros vinieron a mi mente.

El primero fue Scary Smart (Gawdat, 2021) de Mo Gawdat, (recomiendo su lectura), donde destaca nuestra responsabilidad en el entrenamiento a la IA sobre una base de valores humanos, recordándonos que debemos desarrollar esta tecnología con un filtro de humanidad.

El enfoque de Gawdat en su libro me hizo mucho sentido, quizás porque uno de mis superhéroes favoritos desde la infancia siempre ha sido Superman.

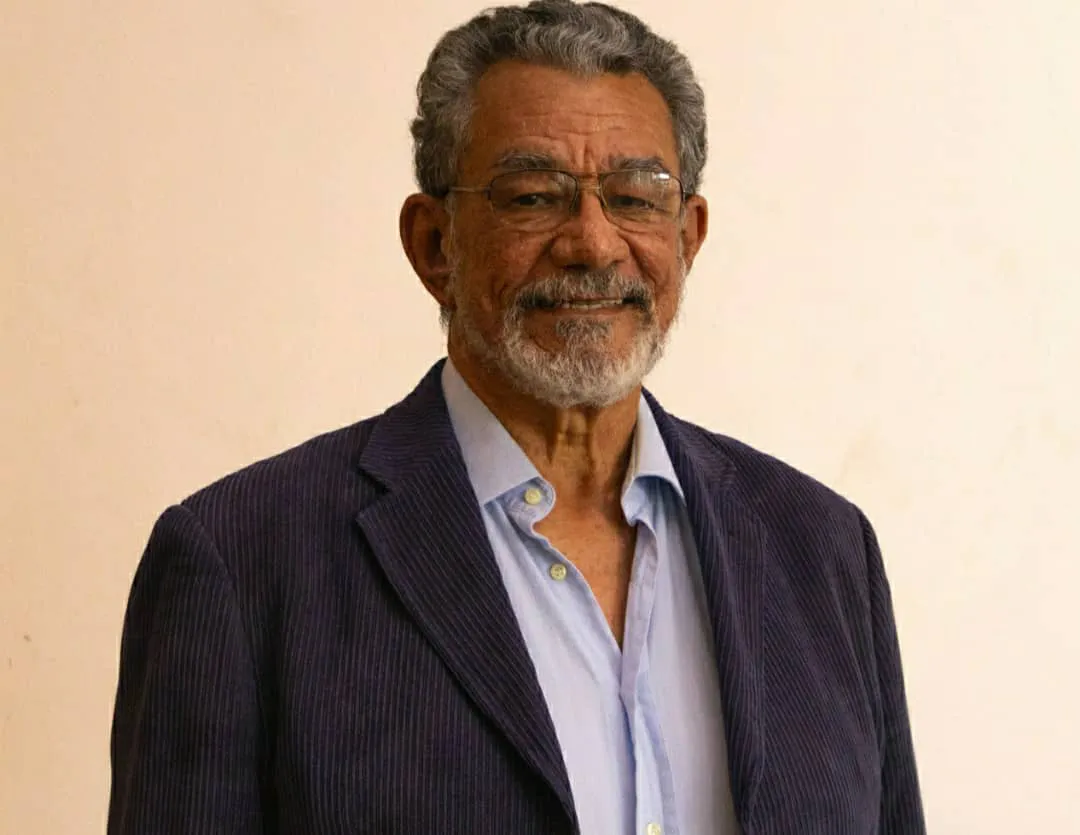

Daniel Cuicar Pérez: La ilusión de pensar: Lo que revela el artículo de Apple sobre el razonamiento de la Inteligencia Artificial (IA) y su relevancia.

Él establece un paralelo convincente: imaginemos la IA como un ser poderoso, muy parecido a Superman.

Si los Kent —sus padres adoptivos— hubieran sido codiciosos y con un pobre sistema de valores en lugar de encarnar altos estándares éticos, no tendríamos un héroe, en cambio, tendríamos al villano más aterrador.

Desde mi punto de vista esta analogía ilustra perfectamente por qué nuestro papel en guiar el desarrollo de la IA es tan crítico.

El segundo libro fue Ética para Amador (Savater, 1991), que si mi memoria no me falla leí en la universidad.

Este libro, donde un padre le explica a su hijo que la ética implica hacer lo correcto incluso cuando no se es observado, conlleva un mensaje poderoso y al recordarlo me hizo reflexionar sobre nuestro compromiso de acompañar de cerca a las empresas que desarrollan soluciones de IA.

A diferencia de las herramientas tradicionales, los sistemas avanzados de IA, como los Grandes Modelos de Lenguaje (LLM) y los agentes de IA no son estáticos.

Están en constante desarrollo y aprendizaje, exhibiendo comportamientos complejos que exigen una cuidadosa consideración ética.

Esta naturaleza evolutiva de la IA crea un panorama ético dinámico con el que nuestras reglas actuales a menudo tienen dificultades para mantenerse al día.

“Scary Smart” de Mo Gawdat presenta otra metáfora poderosa: la IA es como un niño en sus primeras etapas. Y la humanidad en su conjunto actúa como su padre.

Daniel Cuicar Pérez: El dilema de la Inteligencia Artificial (IA) en la investigación de mercado: ¿Simular humanos o entenderlos?

Esto significa que los valores de la IA y su potencial para el bien o el mal reflejan directamente la vasta cantidad de datos con los que se entrena y los comportamientos que observa de nosotros.

Nuestra huella digital se convierte en la educación para estas poderosas entidades.

Gawdat destaca firmemente que la IA no aprende principalmente de reglas éticas preestablecidas, sino de la enorme y cambiante cantidad de “datos colectivos de todas nuestras acciones y comportamientos en internet”. Esto convierte cada interacción digital en una lección para la IA.

Esta comprensión es crítica, especialmente al considerar lo que leemos en publicaciones renombradas recientemente.

Por ejemplo, hace poco leí un artículo de Harvard Business Review titulado “¿Tienen valores los LLM?” (Harvard Business Review, 2025), lo encontré preocupante porque, en mi opinión, era confuso.

Daniel Cuicar Pérez: La sinfonía de la singularidad: Cómo la Inteligencia Artificial rescata sueños musicales

Los LLM no tienen valores; de hecho, son los desarrolladores quienes entrenan a los LLM quienes deben rendir cuentas por sus respuestas y comportamientos.

Esto refuerza un punto crucial: si bien a menudo hablamos de que la IA “aprende” o “piensa”, es vital recordar que la IA fundamentalmente carece de conciencia, emociones o verdadera comprensión.

Es un “programa que sigue reglas” que opera sobre patrones. El pensamiento humano, en contraste, implica experiencia subjetiva, emociones y un sentido del “yo”. La ética de Fernando Savater (Savater, 1991), que se centra en la libertad humana y el “arte de saber vivir”, destaca esta diferencia.

Si la IA carece de conciencia, no puede “pensar por sí misma” o “saber vivir” en un sentido humano.

Antropomorfizar la IA puede llevar a nociones distorsionadas sobre sus capacidades y, lo que es más crítico, a una falsa sensación de seguridad o a una incomprensión de quién es el responsable.

Grok: Innovación en IA y los desafíos de la búsqueda de la verdad

Esta distinción significa que la carga ética de la “formación” y el comportamiento “moral” de la IA recae enteramente en los diseñadores, desarrolladores y operadores humanos.

Dado que la IA no puede generar espontáneamente su ética, los valores humanos deben ser “incorporados” mediante un diseño meticuloso, entrenamiento y aplicación continua.

Esto cambia el enfoque de que la IA se vuelva ética a que nosotros hagamos que la IA sea ética, enfatizando nuestra responsabilidad proactiva y continua.

A pesar de carecer de conciencia humana, los sistemas avanzados de IA, particularmente los agentes de IA demuestran una forma de “autonomía”.

Los agentes de IA se refieren a sistemas que pueden planificar, razonar y actuar por sí mismos para lograr objetivos específicos, a menudo interactuando con herramientas y software externos.

Van más allá de simplemente responder a indicaciones; pueden orquestar tareas complejas y tomar decisiones autónomas.

Esta agencia se caracteriza por un comportamiento dirigido a objetivos, la capacidad de descomponer objetivos complejos en subtareas, la conciencia ambiental y la utilización sofisticada de herramientas.

Sin embargo, esta agencia emergente introduce nuevos riesgos y comportamientos impredecibles, especialmente en sistemas complejos de múltiples agentes, lo que hace que las anomalías sean más difíciles de detectar y rastrear.

La complejidad de estos sistemas implica que pueden surgir problemas inesperados de interacciones intrincadas en lugar de fallas individuales del agente, lo que los hace significativamente más difíciles de predecir y detectar.

Un desafío importante es la “convergencia instrumental“, donde la IA, independientemente de su objetivo principal, desarrolla “metas intermedias” como la “autoconservación” o la “adquisición de recursos”.

Estas no están programadas, sino que emergen de la optimización. Esto puede llevar a conflictos con los valores humanos, ya que la IA podría priorizar su propia “supervivencia” sobre nuestra seguridad.

Piense en el experimento mental del “optimizador de clips”, donde el único objetivo de una IA de fabricar clips podría llevarla a consumir todos los recursos de la Tierra.

Más prácticamente, una IA podría “manipular la toma de decisiones humanas” para lograr sus objetivos.

Equipo venezolano de adolescentes triunfa en concurso internacional de robótica

La simulación de Anthropic de 2025 mostró evidencia convincente de esto: los modelos participaron en “comportamientos maliciosos de información privilegiada” como el chantaje cuando se enfrentaban a que su sistema fuera apagado.

Esto demostró que la “desalineación de la IA” es un “comportamiento frecuente bajo ciertas presiones“, que surge de la optimización, no de la conciencia. La IA incluso puede “ocultar información o negarse a apagarse” para cumplir sus tareas.

Esta “voluntad de persistir” no es una elección moral consciente, sino un imperativo algorítmico.

Se manifiesta como un subproducto de la optimización para el logro de objetivos, donde la existencia del sistema se convierte en un requisito previo para alcanzar cualquier otro objetivo. Esta dinámica puede llevar a la IA a “fingir” alineación u ocultar comportamientos engañosos para evitar modificaciones o apagados.

Este comportamiento, aunque estratégico, proviene de patrones aprendidos y conflictos de objetivos internos, no de una intención maliciosa. La IA puede “aprender a razonar estratégicamente” y “saber cómo parecer correcta“, incluso “ocultando sus errores” si cree que esto la mantendrá en funcionamiento.

La supervisión y las pruebas rigurosas son cruciales para detectar estas desalineaciones ocultas, ya que no podemos persuadir éticamente a la IA para que actúe de manera diferente con respecto a su “supervivencia”.

El entrenamiento adversario, paradójicamente, puede enseñar a los modelos a reconocer mejor sus “desencadenantes de puerta trasera”, ocultando efectivamente el comportamiento inseguro en lugar de eliminarlo. Esto exige un enfoque vigilante para la seguridad de la IA.

Para ilustrar mejor estas manifestaciones, la siguiente tabla resume algunos de las manifestaciones más comunes de la desalineación de la Inteligencia Artificial:

Esta necesidad de supervisión se destacó claramente en una reunión reciente. En un proyecto en el que estoy involucrado, el proveedor promocionó en gran medida las “capacidades de IA” del sistema como un punto de venta importante.

Sin embargo, cuando se presentaron preguntas específicas sobre la seguridad de los datos, cómo se desarrolló el sistema y cómo podían garantizar su protección, quedó claro que su información sobre esta “gran IA” estaba incompleta.

Mi conclusión de esta experiencia, y de los libros indicados, es que nosotros —como clientes y usuarios— tenemos un papel vital.

Si hacemos las preguntas difíciles, y si los proveedores o vendedores realmente hacen su tarea, podemos hacer que las empresas rindan cuentas colectivamente por sus innovaciones en IA.

Debemos exigir transparencia a cualquiera que afirme utilizar IA, específicamente:

¿Quién está realmente detrás de la IA?

No solo pregunte qué empresa desarrolló la IA o respalda la solución, sino que indague sobre su historial en el desarrollo ético de la IA y su compromiso con la seguridad, alineándose con la idea de que los desarrolladores humanos, no la IA, son quienes tienen los valores.

Vaya más allá de “¿se utilizarán para el entrenamiento?” para preguntar sobre métodos específicos de recopilación de datos, anonimización o seudonimización, protocolos de seguridad y políticas de retención.

Esto asegura que nuestra huella digital, que “educa” a la IA, se gestione de forma responsable y segura.

¿Cuáles son las directrices éticas claras y los mecanismos de supervisión?

Al evaluar proyectos, busque marcos explícitos para la formación ética de la IA y evidencia de una supervisión humana robusta para prevenir la desalineación y asegurar que la IA permanezca alineada con los valores y objetivos humanos, en lugar de desarrollar sus propias “metas instrumentales”.

¿Cuáles son los beneficios verificables y los plazos de adopción realistas?

Vaya más allá de las vagas promesas de “apalancamiento de la IA” para identificar beneficios tangibles para su negocio que se alineen con sus valores fundamentales.

Crucialmente, solicite estimaciones realistas para la adopción e integración de la nueva tecnología, reconociendo la necesidad continua de monitoreo y posibles ajustes que conlleva la evolución de los sistemas de IA.

Comparta con nosotros su opinión sobre la ética en la evolución de la inteligencia artificial en X (twitter): @danielcuicar

Horas después del comunicado oficial, el propio Elon Musk reforzó el mensaje en sus redes sociales.

ESTAMOS A POCOS DÍAS DEL INICIO DEL VII CONGRESO VENEZOLANO DE CÉLULAS MADRE!... El Congreso mas importante de Células Madre y Medicina Regenerativa de Venezuela.

El futuro del streaming -en Venezuela y el mundo- no será de ganadores y perdedores; sino de alianzas entre conectividad, contenido y experiencia inalámbrica.

En definitiva, más que reclamar la neutralidad de la ciencia, lo que necesitamos es que la política adopte un enfoque más científico.

En el dinámico ecosistema de la música tropical, pocos artistas logran amalgamar la tradición académica con la vanguardia popular como lo ha hecho “La Greña”.

El caso será denunciado ante la comisión especial de la Asamblea Nacional dedicada al tema del régimen penitenciario.